苏小枫,陈清华

1(浙江工业大学 计算机科学与技术学院,杭州 310014)2(温州职业技术学院 信息技术系,浙江 温州 325035)

无线供能通信(Wireless Powered Communication,WPC)是指低功耗设备从专门的射频源中捕获能量并存储在自身电池或者电容中,用于支持设备传感、计算和数据传输等任务,被广泛应用于环境检测、智能家居等领域[1-3].得益于电路技术在硬件灵敏度、射频-直流转换效率、电路功耗等方面的最新发展[4,5],设备可直接捕获环境射频源(如广播基站、WIFI等)的广播信号实现长期工作,进一步降低总成本.

然而,当周围环境射频信号较弱或者射频源周期性工作时,设备需要很长时间来积累足够能量用于主动传输,从而降低数据传输效率.作为射频供能通信的另一方式,反向散射通信可以很好地弥补这一局限.反向散射通信是指发送端将一系列数字信号映射到天线处的射频反向散射波形上,通过调整天线的负载阻抗来产生与原始信号不同的波形,根据射频源与接收端的不同,可分成单站反向散射、双站反向散射和环境反向散射3类.单站反向散射通信系统应用最广泛的是射频识别系统[6],然而,射频识别系统的射频源和接收端在同一仪器上,存在往返路径损耗和双远近效应问题.针对该问题,Lu等人部署专门射频源提高性能,但增加了部署成本[4].Lyu则研究了环境反向散射射频通信网络,利用环境中存在的射频源(如调幅广播基站、电视信号塔、蜂窝基站等)作为自身射频源[7],该方法不仅降低了功耗和总体成本,而且不需要分配新的频谱.然而,环境反向散射通信存在射频源工作频率和周期不可控的缺点,性能会因信道和环境因素(如环境能源的分布、空间密度和传输负载)发生改变[8],数据传输速率与距离都小于主动通信,仅在稳定的射频源情况下才可正常工作.为此,学者提出了混合反向散射和无线供能通信的设备硬件设计,在无法捕获到足够能量进行主动通信[9],在有足够能量但缺乏主动通信机会时,反向散射通信是一种有效的补充方式.

在研究混合通信时,通常以吞吐量作为评价指标,由于吞吐量的计算过程大多采用香农公式[10,11],意味着即使发送端存在少部分能量也可以进行数据传输,这与通信协议中以数据包为单位传输不符.为此,部分研究以收包率作为评价通信性能的另一指标[12,13].Wu认为收包率与接收端的功率阈值有关,以数学公式的形式,计算了在不同网络参数(如功率接收阈值、收发机距离、发射功率)下系统的丢包率[14].Zhang在认知异构网络中,考虑了智能切换调制编码技术,并给出了不同调制技术的误码率与信噪比关系[15],但均未考虑包长度与收包率的关系,且所考虑的数据量无限.

在混合通信求解最佳策略中,通过建立马尔可夫决策过程,并使用值迭代算法求解是常见的步骤,但值迭代方法以遍历的形式求得全局最优解[16],需要已知所有状态信息和转移概率,不能解决实际环境量部分未知且状态空间连续.深度强化学习方法在解决高维连续问题上独具优势,已在场景同样复杂的边缘计算[17-19]、智能无人机领域[20,21]和点到点通信[22]广泛运用,解决部分可观测的马尔可夫决策过程最优策略问题,例如Zhang将长期集群吞吐量最大化问题归结为部分可观测的马尔可夫决策过程,提出了一种基于深度强化学习的无授权算法[19],以较少的冲突了解网络竞争状态、输出子信道和接收功率电平选择.

因此,考虑使用深度强化学习解决混合通信状态连续问题.本文从链路层方面研究混合通信的性能,考虑有限的电池电量和数据量,给出反向散射和无线供能通信的收包率计算过程,并采用无先验信息的算法解决环境的动态变化问题,运用深度Q学习算法解决状态空间连续问题.具体来说,发送端以数据包为单位传输,其收包率受比特级误码率和包长度影响,误码率需根据信噪比和调制解调方式计算.随后,由于信号受周围环境的影响,且环境是动态变化,无法事先了解周围信息,通过基于无模型的方法可以得到相对较优解,更适用于实际环境.同时考虑数据信息量大、状态空间连续情况,运用深度Q学习算法,通过神经网络对状态空间拟合化处理求解最优策略.

本文考虑单用户通信网络框架:一种低功耗物联网设备,其发射机支持无线供能和后向散射通信作为发送端.在射频源通信时可捕获能量或被动反向散射传输,在射频源不通信时可主动传输数据给接收端.在这种情况下,本文旨在探索一种完全在线的策略,确定选择的工作模式并分配无线供能通信的发射功率,从而最大限度地提高长期平均收包率.同时,还考虑了电池容量有限和时变数据传输信道等实际约束条件.具体而言,本工作主要贡献如下:

1)提出基于信干噪比的反向散射和无线供能通信的误码率计算过程,并通过误码率和数据包长度计算收包率;

2)通过工作模式选择和功率分配实现收包率最大化,在环境动态变化、有限能量和数据量约束下构建马尔可夫决策过程,提出数据丢包开销问题,根据所归纳的问题,提出基于无先验信息的SARSA在线最优策略求解方法和基于连续状态的深度Q学习算法;

3)在不同参数下探寻收包率的有效性和稳定性,通过广泛模拟,比较不同强化学习方法的性能,发现基于SARSA和深度Q学习的在线解决方案性能优于基线方案Q学习.

2.1 系统模型

考虑如图1所示的系统模型,该模型由基站、移动用户和物联网设备构成.物联网设备消耗自身存储的能量用于工作,而后将所采集得到的数据封装成包发送给移动设备,物联网设备自身不与基站通信.因此,在用户通信,即信道忙碌时,物联网设备可以捕获基站发射的射频能或者是通过基站的射频信号反向散射传输数据给移动用户.而当信道空闲时,物联网设备可以消耗自身存储的能量产生射频信号实现无线供能通信.考虑一种情况,当用户与基站通信时,物联网设备也可以消耗能量传输数据,但此时在用户处其接收信号会接收到来自基站的干扰,使本次传输的数据包更容易丢失,即便如此,在数据包与能量均充足,且用户一直在通信的情况下,物联网设备可以通过该方式提升传输效率.

图1 系统模型

2.2 能量捕获模型

在本文考虑的系统模型中,射频源为无线接入点或者WIFI等,这类射频源的特点是传输距离短,发射功率小.因此物联网设备在能量捕获的过程中,需要考虑信道增益,捕获功率为:

(1)

其中,ζ是与能量转化效率,λ表示路径损耗指数,dH是射频源到物联网设备的距离,h1是从射频源到物联网设备间的信道增益辐值的平方,PT是射频源的发射功率.

2.3 传输信道模型

对于无线供能通信部分,不仅需要考虑大规模的路径损耗过程,也需要考虑小规模的块间瑞利信道衰落.对于反向散射通信,由于其传输电路的设置,其物联网设备至移动用户间的通信过程在考虑路径损耗和信道衰落之外,还要考虑反向散射通信系数.特别的是,当物联网设备与移动用户间的距离确定时,其大规模的路径损耗为常数,而小规模信道衰落被认为在块间保持不变,在不同的块之间相互独立且服从瑞利分布,令h表示信道增益辐值的平方,信道增益在每个块内保持不变,在不同的块间独立同分布.h(n)是块n的信道状态,f(h(n))是变量h(n)的概率密度函数,有:

f(h(n))=exp(-h(n)),h(n)≥0

(2)

本节将研究问题纳入马尔可夫决策过程框架,详细介绍系统状态空间、动作空间、奖励空间、转移概率,最后归纳问题的数学形式.

3.1 马尔可夫决策过程

在移动用户概率性通信的情况下,基于包级别的数据传输,根据物联网设备的电池能量和数据包队列状态,得到使得长期平均收包率最大化的物联网设备工作模式和主动传输功率.将该问题建模为部分可观测的马尔可夫决策过程,由四元组{S,A,R,P}组成,其中S是系统的状态空间,A是动作空间,R是奖励空间,P是转移概率.以下是这4个要素的详细说明.

1)系统状态空间S:在块n的开始,物联网设备已知当前的系统状态Sn∈S,包括环境信道状态h(n)、能量队列b(n)和数据包队列q(n),即Sn={h(n),b(n),q(n)},其中h(n)∈{0,1},h(n)∈{0,1,…,qmax}.h(n)=1表示射频源处于通信状态,物联网设备周围有射频信号,为0则代表不存在射频信号.q(n)表示数据队列中数据包的个数,以离散化状态表示,qmax为最大数据包容量.b(n)表示电池能量状态,bmax为最大电池容量,超出的能量将被舍弃.

(3)

3)转移概率P:在采用动作An下,状态Sn变成Sn+1的转移概率为P(Sn+1|Sn,An).当状态空间连续时,P(Sn+1|Sn,An)为Sn+1的条件概率密度函数.由于信道状态h(n+1)、能量队列b(n+1)和数据队列q(n+1)相互独立:

P(S(n+1)│Sn,An)=P(h(n+1)│Sn,An)×

P(b(n+1)│Sn,An)×P(q(n+1)│Sn,An),∀S(n+1)∈S

(4)

式中η表示当前环境信道忙碌概率,则空闲概率用1-η表示.由于信道状态在块间相互独立,无论当前信道为忙碌或空闲,下一状态的信道忙碌概率不变,因此P(h(n+1)│Sn,An)为:

(5)

对于P(b(n+1)│Sn,An),根据所选择动作不同,转移概率有3种情况:

①当e(n)=0或2,即物联网设备休眠或反向散射传输时,由于节点休眠时不消耗任何能量,反向散射过程中消耗的能量忽略不计,因此有

P(b(n+1)│Sn,An)=1(b(n+1)=b(n)),

∀b(n+1)∈[0,bmax]

(6)

1(X)为指示函数,当X满足时该函数为1,反之则为0.

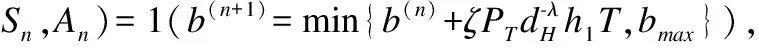

②当e(n)=1,即物联网设备进行能量捕获时,天线从环境中接收射频信号,通过电路将其转化为电能并存储在能量模块中,同时存储的能量不能超过最大电池容量限制:

∀b(n+1)∈[0,bmax]

(7)

③当e(n)=3,即物联网设备进行主动传输数据时,物联网设备消耗存储能量生成射频信号,通过调制编码传输数据.消耗的能量与主动传输发射功率和传输时间有关.值得注意的是,消耗的能量不得超过已存储的能量,这需要在发射功率的选择上加以调整.

P(b(n+1)│Sn,An)=1(b(n+1)=max{b(n)-pt(n)T,0}),

∀b(n+1)∈[0,bmax]

(8)

对于P(qn+1│Sn,An),根据所选择动作不同,其转移概率也有3种情况:

①当e(n)=0或1,即物联网设备休眠或捕获能量时,本文假设发送端以概率ω(ω∈[0,1])到达qr个数据包,因此P(q(n+1)│Sn,An)为:

(9)

②当e(n)=2,即物联网设备反向散射传输数据时,考虑数据包的到达,其转移概率为:

(10)

qb为反向散射通信传输的数据包数:

人的活动尺度是指人在一个空间内的进行基本活动的尺度。在专业教室中,一般使用者为教师与学生,在教室内的活动主要有授课、听课、绘图、站立、行走、讨论、制作模型等。但这些活动的基础实际上就是站、坐、行三种。

qb=vbT×Pb

(11)

vb为反向散射传输数据包的速率,表示为比特传输速率与包长度的商,Pb为反向散射通信过程中的收包率,表示为:

Pb=(1-Wb)L

(12)

Wb为反向散射通信的误码率,将在后文做详细说明,L为数据包的长度.

③当e(n)=3,即物联网设备主动传输数据时,同样考虑数据包的到达,其转移概率为:

(13)

qa为反向散射通信传输的数据包数:

qa=vaT×Pa

(14)

Pa为主动通信过程中的收包率.本文假设无论射频源是否处于工作状态,物联网设备都可以消耗自身的能量用于主动传输.由于设备要求,至少需要消耗bth的能量才满足最低要求,其收包率可表示为:

Pa=(1-Wa)L·1(b(n)≥bth)

(15)

Wa为主动通信中的误码率.

(16)

3.2 开销问题

物联网设备工作过程中,在块n且数据包队列已满时,根据数据包到达概率,此时仍会有数据包概率性进入,产生数据包丢弃.因此,设定权重α表示丢弃数据包对策略的影响程度,存储容量限制代价函数Cn表示为:

Cn=αmin(0,qmax-q(n+1))

(17)

3.3 问题表述

(18)

马尔可夫决策过程的目标就是找到使得长期平均收包率最大化的最优策略,问题表述为:

(P1):maxJ(π)

s.t.(3),(4),(12),(15),(16),

(17)

4.1 误码率计算过程

在上节所提出的马尔可夫决策过程的奖励空间中,根据不同状态所得的收包率与误码率有关,其计算过程如下:

1)反向散射通信误码率计算过程:误码率与节点所采用的调制技术有关,在反向散射过程中大多采用ASK编码技术,其误码率为:

(19)

(20)

δ1和δ2分别为物联网设备与移动用户处的噪声功率,Nt表示反向散射传输一比特数据所需的符号数.由于反向散射的调制是将Nt个射频信号转变成一个反向散射信号,主动通信的频率是反向散射的Nt倍.

2)主动传输误码率计算过程:主动通信所采用编码方式为QPSK,其误码率与信噪比关系为:

(21)

在主动通信信噪比计算中,仅需考虑物联网设备至移动用户间通信过程,当信道空闲时,移动用户处仅考虑环境噪声;

当信道忙碌时,移动用户需考虑射频源信号对信噪比的干扰,d1和h1分别为射频源与移动用户之间距离和信道增益.因此,当信道空闲时,信噪比表示为:

(22)

当信道忙碌时,信干噪比表示为:

(23)

4.2 基于SARSA的收包率最大化策略求解

由于信道概率性忙碌和数据概率性到达,无法使用值迭代这种离线方法对本问题进行求解,因为值迭代会寻找最优的下一状态进行状态转移过程,在数据包低到达概率的收包率会与高到达概率一致,这与模型设定不符.采用SARSA在线学习法对本文所归纳问题求解.SARSA学习法定义了策略π下动作值函数qπ(s,a).表示从状态s起执行动作a,此后遵循策略π得到带折扣的期望累积奖励,即

qπ(s,a)=

(24)

其中γ∈[0,1]是折扣因子,γ越大表示代理越重视未来奖励.强化学习定理证明如果采用表格法使得对于每个状态动作对qπ(s,a)的估计都是准确的,则使得J(π)取得最大值的最优策略π*有着最优动作值函数,即:

(25)

SARSA法采用ε-贪婪策略,其思想是给定初始策略π和任意的动作值函数qπ(s,a),不断交替进行策略提高和值函数更新.在块n给定状态Sn,遵循策略π选择动作An,收到立即奖励Rn并进入下一个状态Sn+1,再遵循策略π选择动作An+1然后更新qπ使其接近当前策略π的动作值函数:

Q(Sn,An)←Q(Sn,An)+

μ(Rn-Cn+γQ(Sn+1,An+1)-Q(Sn,An))

(26)

u为学习率,使用五元组{Sn,An,Rn,Sn+1,An+1}更新公式.相较于基线的Q学习方法,SARSA使用在线控制策略求最优动作,在当前状态选择动作和依据下一状态选择下一动作更新Q表都是使用贪婪策略,而Q学习中在选择下一动作时所采用Q值最大的动作.相比而言,Q学习更具冒险性,而SARSA比较保守.

4.3 基于深度Q学习的收包率最大化策略求解

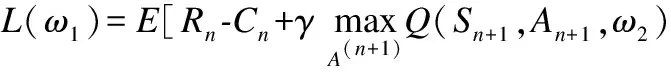

虽然SARSA可以求解无先验信息问题,然而却需要建立表格存储每个状态和动作对应值,这样的方法仅限于状态和动作空间是离散且空间维度不高情况.当状态空间是高维或连续时,使用表格法计算复杂度过高.深度神经网络在特征提取方面有非常好效果,本小节采用深度Q学习(DQL)方法来求解连续状态空间的马尔可夫决策过程.将连续状态转化为函数拟合问题,仅将动作空间离散化,通过函数近似方式去估计值函数,使得相近的状态得到相同动作.

为了解决使用非线性网络表示值函数时出现不稳定等问题,DQL创建原始神经网络,其中用Q(Sn,An,ω1)表示当前网络的输出,来评估当前状态动作对的值函数,称为Q现实,还创建了目标神经网络,计算得到Q(Sn,An,ω2)称为Q估计.目标网络是一种打乱相关性的机制,DQL中会出现两个结构完全相同但是参数不同的网络,用最新的参数预测原始网络的Q估计,而用旧参数预测目标网络的Q现实.在一段时间里Q现实的参数保持不变,在一定程度上降低了Q现实和Q估计的相关性,提高了算法稳定性.而后经过一定次数迭代,再将原始网络参数复制给目标网络,保证其值函数的时效.

本文中两个网络都采用卷积神经网络,包括输入层、卷积层、激活函数、全连接层和输出层.其中通过卷积层将输入的Sn转变为高维,扩充输入层信息;

激活函数采用非饱和线性单元ReLU代替传统sigmoid函数,加速了网络训练的速度,降低了计算的复杂度,对各种干扰更加具有鲁棒性,并且在一定程度上避免了梯度消失问题;

全连接层通过矩阵乘法,实现神经网络从高维转变为低维,并保留有用信息,最后通过分类输出每一个动作An的Q值.目标网络输入层仅为状态Sn,原始网络输入层除了状态Sn外,还需要目标值target.对于MDP四元组(Sn,An,Rn-Cn,Sn+1),DQL目标值满足:

(27)

原始网络在经验池中选取样本,通过目标网络得到选取每一样本对应的目标值,通过损失函数和梯度下降方法更新原始网络参数,其损失函数为:

-Q(Sn,An,ω1)]2

(28)

该损失函数是一个残差模型,表示为Q(Sn,An,ω1)和预测值之间差的平方.过程如图2所示.

图2 DQL算法结构

此外,DQL采用经验回放机制克服了学习算法的不稳定性,并在一定程度上解决相关性及非静态分布问题.经验池的数据结构为队列,以先进先出的原则存储数据.当达到最大容量时覆盖最先存储的数据,保证数据的时效性.当需要使用样本时,通过指针实现随机取一部分样本作为神经网络的输入,更新神经网络参数,打乱神经网络多次输入数据间的相关性,极大程度上地满足神经网络作为有监督学习对输入数据的独立同分布要求.因此,神经网络不仅可以学习当前的经历,还可以学习曾经的经验,提高神经网络的效率.

DQL算法在算法1中描述.算法的输入包括学习率u、折扣因子γ、训练间隔Nb、参数更新间隔Nw、训练所取样本数Ns、贪婪因子ε、经验池容量LM和神经网络参数ω1、ω2.输出为状态动作对的Q值.算法的训练过程分成内外两个循环,其中外循环为迭代过程,通过不同的初始状态输入,尽可能遍历所有情况,通过内循环不断更新神经网络参数,使所得策略不断逼近最优策略.内循环为神经网络参数更新过程.具体地说,在块n时,状态为状态Sn(初始值为S0),首先通过ε贪婪策略选择动作,贪婪策略是指以ε的概率从动作空间中随机选择一个动作,以1-ε的概率选择Q(Sn,An,ω1)值最大的动作.然后将所得的状态与动作通过前文所提出的状态转移、奖励值和开销计算公式,得到下一状态Sn+1、当前报酬Rn-Cn,并整合成样本(Sn,An,Rn-Cn,Sn+1)存储在经验池中,便于后续采用,重复这一过程直至循环结束.这一过程模拟环境的按时序变化,但贪婪策略在选择动作时需通过神经网络计算Q值,需要更新神经网络以便找到每个状态所对应的最优策略.为此在内循环中加入训练过程,即每隔Nb个时间块,从经验池中随机抽取一小批Ns个样本作为神经网络的输入,通过公式(27)、公式(28)和梯度下降法更新参数ω1,同时为打乱样本间的相关性,此过程不更新参数ω2.为保证目标神经网络参数的时效性,每隔Nw个时间块使两个神经网络的参数相等.

算法1.最大化混合通信收包率算法

输入:u,γ,Nb,Ns,Nw,ε,LM,ω1,ω2

输出:Q(Sn,An,ω1)

1.forepisode=0,1,2,…do

2. 初始化状态S0

3.forn=0,1,2,…,nmaxdo

4. 随机产生0到1之间的一个数p

5.ifp≤εthen

6. 随机选择一个行为An

7.else

8. 将状态Sn(初始值为S0)作为参数输入原始神经网络,得到所有行为的Q(Sn,An,ω1)集合,选择Q值最大的行为An

9.endif

10. 得到环境中的信道增益,并根据状态Sn和行为An,从环境中得到报酬Rn-Cn,环境状态变为Sn+1

11. 将样本(Sn,An,Rn-Cn,Sn+1)存储至经验池中

12. 每隔Nb次抽取Ns个样本,并利用目标神经网络和计算每个样本的目标值

13. 利用损失函数和梯度下降方法更新原始神经网络的参数ω1

14. 每隔Nw次更新目标神经网络参数ω2=ω1

15.endfor

16.endfor

5.1 实验设置

采用Python3.8实现文中算法,实验环境Win10系统,Intel Core i5 2.40GHz CPU,8GB内存.使用Tensor Flow搭建卷积神经网络,神经网络隐藏层间均为全连接,且每层隐藏层有100个神经元.SARSA、Q学习和深度Q网络的学习率和折扣因子一致,分别为0.001和0.9,ε初始值设置为1,并在每次迭代过程中以0.995的相关系数降低直至0.1.随机抽取的样本数目Ns为32,总样本容量LM为500.内循环次数nmax为1000,Nb=5,Nw=200.反向散射和主动通信的传输速率分别为10kbps和30kbps,数据到达速率为5kbps,计算包个数向上取整.数据包的长度受反向散射通信协议限制,取值范围为48-528比特,且为8的倍数,本文实验为128比特.其他实验参数设置见表1.

表1 实验参数设置

5.2 实验结果与分析

本小节通过改变不同的参数,使用SARSA算法对本章节所归纳的数学模型进行求解,比较长期平均收包率.考虑强化学习算法仅能得到最优策略,因此从任一状态开始,依照最优策略选择动作,进而状态转移并计算报酬,重复1000次取报酬平均值即为最终的长期平均收包率.

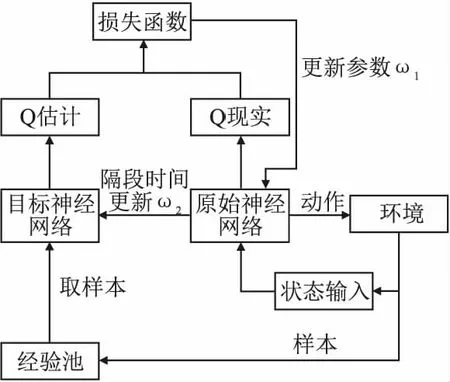

首先,在不同的数据包长度下,比较信道忙碌概率与收包率之间的关系.由图3可以看出,无论数据包长度为何值,收包率总是随着信道忙碌概率的增加而增加.这是因为随着信道概率增加,物联网设备具有更高的可能性进行捕获后传输或者是反向散射通信,从而提升整体收包率.对于不同数据包长度而言,数据包长度越小,收包率越高,这是因为收包率是误码率的幂函数,呈正相关变化.在高信道概率情况下,收包率差距较为明显.当信道概率为0.9时,L=256时的收包率相对于L=512提升了5%,当信道概率为1时,L=128时的收包率相对于L=256提升了7.5%,这是因为在信道忙碌时,物联网设备更有可能进行反向散射和有干扰的主动传输,这两种通信所产生的收包率都低于无干扰的主动传输,因此数据包长度对收包率影响明显.

图3 不同包长度下信道忙碌概率对收包率的影响

而当信道忙碌概率较低时,出现数据包长度越大,收包率越高的情况,此时3种数据包情况所得的收包率接近,但由于数据容量限制代价函数的影响,数据包长度越小,所接收数据包越多,接收数据包越容易达到数据存储最大容量,丢包代价越高,收包率越低.

其次,在不同数据包长度下,比较数据包到达概率对收包率的影响,如图4所示.随着数据包到达概率增加,收包率呈现先增加后平缓的趋势.这是因为低到达概率情况下,数据包较少,未能到达通信所需的最少数据包数,物联网设备只能采取休眠或能量捕获,而在本文中认为该类动作收包率为0,因此收包率较低.在高到达概率时,数据队列中的数据包数已达到传输要求,因此到达概率增加并不会对收包率造成影响.同样,由于不同包长度原因,传输所要求的最小数据包不一致,数据包长度越大,所要求的数据包值越小,到达概率较低便可满足传输条件,也就是长度越大,越早趋于平缓的原因.对于不同数据长度对收包率的影响.在高数据到达概率时,数据包长度越小,收包率越高,是因为数据量充足的情况下收包率与包长正相关.在数据低到达概率下,包长度越长就越容易有足够的数据包进行传输,从而收包率也就越高.

图4 不同包长度下数据到达概率对收包率的影响

然后,由于本文假定在信道忙碌时物联网设备可进行主动传输,希望能研究该方案对长期平均收包率的影响,如图5所示,其中HTI表示物联网设备可以在信道忙碌时主动传输,HT则表示无法主动传输.从图中可以看出,当信道忙碌概率较低,即η≤0.6时,该方案对最终结果的影响不大,HT的收包率平均为HTI的98.56%,最低为97.8%.而当信道忙碌概率增加,两条曲线有了较为明显的差值,原因有二,一是信道空闲可能性低,HT主动传输时间少,只能采用收包率较低的反向散射来进行数据传输,尤其是在信道一直处于忙碌(η=1)时,HTI相较于HT提升13%.二是电池能量充足甚至溢出,反向散射速率超过数据到达的速率,因此物联网设备在信道忙碌时不仅可以反向散射传输所接收的数据,还能进行能量捕获,在拥有充足能量情况下,即使存在干扰,主动传输收包率也超过反向散射通信的收包率,因此在0.7≤η≤0.9时,HTI相较于HT平均提升了6.6%,最低也提升了4.27%.由此可见,本文所假设信道忙碌可主动传输方案在高信道概率时能小幅度提升混合通信收包率.

图5 不同传输方案在不同信道忙碌概率下的收包率对比情况

然后,在图6中,研究了本文所提出的SARSA与Q学习、深度Q学习在不同信道忙碌概率的收包率.虽然Q学习在η=0.7时其收包率优于SARSA算法,但在其余情况下均略逊于SARSA算法.在低信道忙碌概率时SARSA相对提升了近15%,正如前文所述,作为同一策略的在线学习算法,SARSA更容易寻找最优策略,从当前状态开始找到一条更优的路线,而不是像Q学习那样只着眼于下一状态最大值,而忽略Q值更新与下一动作之间的关联性,这两类方法的计算复杂度一致.因此,在考虑长期平均目标最优策略求解过程中,SARSA算法比Q学习更适合,能求得更佳的状态-最优动作对,有效提升最终结果.而深度Q学习由于采用神经网络,可以采用连续状态空间,因此所得的最优策略均高于SARSA和Q学习这类表格法,但是神经网络的计算复杂度略高于表格法,而且计算运行时间相对较长,因此应适当根据设备条件和计算能力选择相应强化学习方法.

图6 不同强化学习方法在不同信道忙碌概率下的收包率对比情况

最后,在图7中对比了不同信道忙碌概率下长期平均收包率与瞬时平均收包率.瞬时收包率是指物联网设备仅考虑当前时间块的最佳动作,不考虑采取该动作对后续选择动作的影响,同样计算1000次取平均值,即为瞬时平均收包率.由图7可以看出,长期平均收包率一直高于瞬时平均收包率.在高信道忙碌概率下(η≥0.7),长期平均收包率相较于瞬时收包率平均提升了8.35%,最高提升10.18%;

而在低信道忙碌概率下平均提升52.57%,最高提升了120%(η=0.1时,此时长期平均收包率为0.017,而瞬时平均收包率仅为0.0078).这是因为瞬时收包率仅关注当前情况,无法考虑自身行为对下一状态的影响,在周围信号不足时急于消耗自身资源造成后续传输能力下降,降低系统的收包率.因此,长期平均收包率这一目标可适应较为恶劣的环境,及时调整自身工作模式,显著提升整体网络性能.

图7 长期平均和顺时平均收包率在不同信道忙碌概率下的对比情况

针对混合通信系统收包率优化问题,提出了一个最优策略求解过程,通过工作模式选择和主动传输发射功率分配来最大化长期平均收包率.考虑了信道忙碌状态下物联网设备主动传输方案,提出了数据包容量限制的开销问题并归纳了不同通信方式的误码率和收包率计算过程,而后提出基于在线控制策略的SARSA算法和连续状态的深度Q学习算法来获得在线最优解.通过仿真实验,研究了不同包长度与信道忙碌概率和数据到达概率的关系.此外,对所采用的传输方案和在线算法与Q学习方法进行了对比与分析.在未来希望能考虑多传感器节点的混合通信场景,将强化学习应用于实际,验证其效能.

猜你喜欢 数据包信道射频 二维隐蔽时间信道构建的研究*计算机与数字工程(2022年3期)2022-04-075G OTA射频测试系统汽车工程师(2021年12期)2022-01-17信号/数据处理数字信道接收机中同时双信道选择与处理方法火控雷达技术(2021年2期)2021-07-21低场核磁共振短死时间射频线圈与射频开关的设计波谱学杂志(2021年1期)2021-03-12关于射频前端芯片研发与管理模式的思考军民两用技术与产品(2021年12期)2021-03-09民用飞机飞行模拟机数据包试飞任务优化结合方法研究民用飞机设计与研究(2020年4期)2021-01-21C#串口高效可靠的接收方案设计物联网技术(2018年8期)2018-12-06一种高效多级信道化数字接收机的设计与实现雷达与对抗(2018年3期)2018-10-12一种无人机数据链信道选择和功率控制方法北京航空航天大学学报(2017年3期)2017-11-23腹腔镜射频消融治疗肝血管瘤腹腔镜外科杂志(2016年9期)2016-06-01